隨著大數據時代的到來,海量數據的存儲、管理和處理成為企業面臨的核心挑戰。Hadoop分布式文件系統(HDFS)作為Apache Hadoop生態的基石,提供了高可靠、高擴展性的分布式存儲解決方案,是大數據處理不可或缺的組件。本文將帶您快速入門HDFS,深入解析其數據處理與存儲支持服務。

一、HDFS 核心架構與設計理念

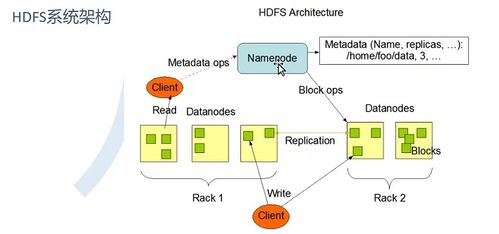

HDFS遵循主從架構,主要由兩個核心組件構成:

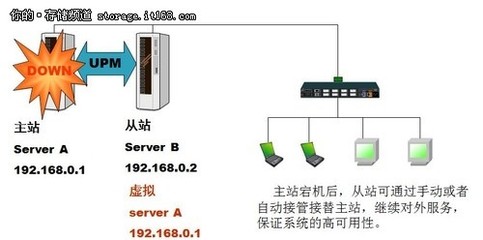

- NameNode(主節點):作為系統的“大腦”,負責管理文件系統的命名空間(如目錄樹、文件元數據)并協調客戶端的訪問。它存儲著文件到數據塊的映射關系以及數據塊在集群中的位置信息。通常配置高可用方案,防止單點故障。

- DataNode(從節點):作為“勞動力”,負責在本地磁盤上實際存儲數據塊,并執行數據塊的讀寫操作。DataNode定期向NameNode發送心跳信號和塊報告,以維持集群的健康狀態。

HDFS的設計理念基于幾個關鍵假設:適合存儲超大文件(GB、TB級);采用“一次寫入,多次讀取”的流式數據訪問模式;部署在廉價的商用硬件上,通過軟件層面的容錯機制保障可靠性。

二、HDFS 數據處理與存儲的核心機制

1. 數據分塊與復制

HDFS將大文件分割成固定大小的數據塊(默認為128MB),這些塊被分散存儲在不同的DataNode上。每個數據塊會有多個副本(默認3個),分布在不同的機架或節點上。這種機制不僅實現了數據的并行處理,還通過冗余存儲確保了數據的高容錯性和可用性。

2. 讀寫流程

- 寫入流程:客戶端向NameNode發起寫請求,NameNode驗證權限后,返回可寫入的DataNode列表。客戶端將數據塊直接寫入第一個DataNode,該節點接收后將其轉發給列表中的下一個節點,形成流水線復制,直到所有副本寫入完成。

- 讀取流程:客戶端向NameNode請求目標文件的數據塊位置信息,然后直接與最近的DataNode建立連接,并行讀取數據塊,最后在客戶端組裝成完整文件。

3. 容錯與恢復

- DataNode故障:NameNode通過缺失的心跳檢測到故障,隨后將故障節點上的數據塊,利用其他副本重新復制到健康的節點上,確保復制因子不變。

- 數據塊損壞:客戶端和DataNode通過校驗和驗證數據完整性。發現損壞時,客戶端會從其他副本讀取,并報告NameNode,觸發損壞塊的修復。

三、HDFS 作為存儲支持服務的關鍵特性

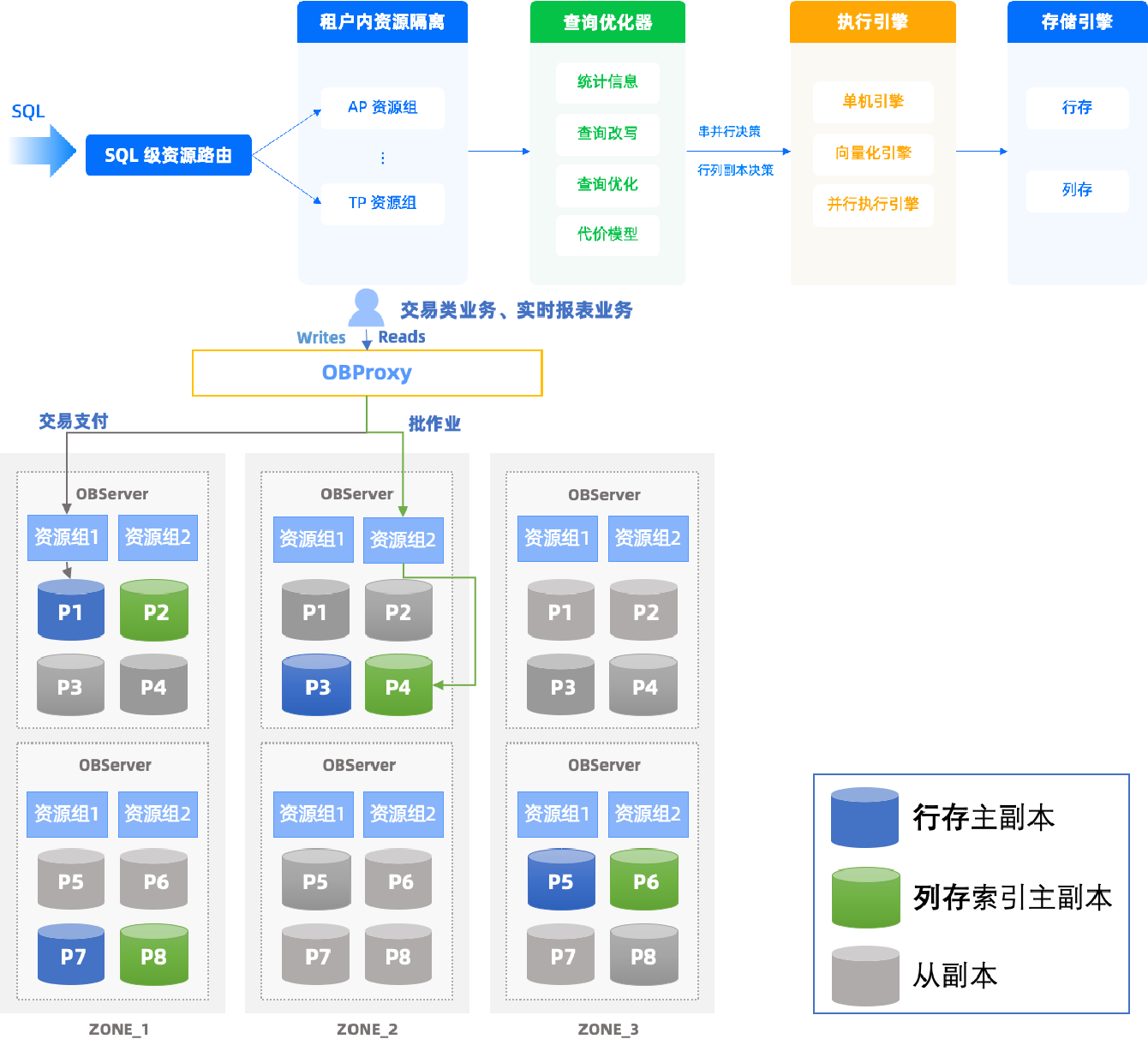

- 高吞吐量訪問:通過數據分塊和并行讀寫,HDFS優化了大數據集的批量處理性能,特別適合MapReduce、Spark等批處理作業。

- 可擴展性:通過橫向添加DataNode,可以輕松擴展存儲容量和計算能力,支持從數百到數千節點的集群。

- 成本效益:設計運行于低成本硬件,通過軟件實現容錯,降低了海量數據存儲的總擁有成本。

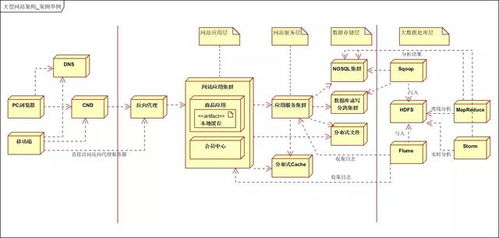

- 生態系統集成:HDFS是Hadoop生態的核心存儲層,與YARN、Hive、HBase、Spark等組件無縫集成,為上層計算框架提供統一、可靠的數據源。

四、快速實踐:基礎操作命令

通過Hadoop Shell命令,可以快速體驗HDFS的基本操作:

hdfs dfs -mkdir /user/test:創建目錄hdfs dfs -put localfile.txt /user/test:上傳本地文件到HDFShdfs dfs -ls /user/test:列出目錄內容hdfs dfs -cat /user/test/localfile.txt:查看文件內容hdfs dfs -get /user/test/localfile.txt .:下載文件到本地

五、與展望

HDFS以其簡潔的架構、強大的容錯能力和出色的擴展性,奠定了大規模數據存儲的基石。對于初學者而言,理解其核心架構、數據存儲機制以及與計算框架的協同方式是快速入門的關鍵。隨著云原生和對象存儲的興起,HDFS也在持續演進(如HDFS EC糾刪碼、與S3的集成),但其作為大數據處理底層可靠存儲服務的核心地位,在可預見的未來仍將不可替代。

要深入掌握,建議在搭建的Hadoop集群上親手實踐,并結合具體項目理解其在完整數據流水線中的應用。